粮食安全关乎国计民生,解决人民的吃饭问题、促进人民福祉始终是党和政府关心的首要问题[1]。粮食储备是连接生产与消费,保障粮食安全的重要环节,不断提升粮食储备的管理水平对维护粮食储备安全生产工作及保障区域粮食安全具有很大的意义[2]。近年来,在基于计算机视觉的粮食数量监测任务中发现,由视频监控系统捕获的仓内图像存在较多异常状况,如粮面覆膜、画面模糊、过度曝光、异物遮挡等。因此,对采集到的仓内图像进行识别和分类,不仅能够及时发现并预警潜在的粮食损失问题,还能提高粮食储备的稳定性和监测的准确性。

在早期,粮食储备监测主要依靠人工巡查,存在效率低、错误率高、工作强度大等问题。为了克服这些挑战,并提高监测与识别的准确性与效率,科学家们开始探索新的技术手段。Mohammad Asefi 等[3]利用电磁成像技术,以及使用有限元对比源反演算法(Finite element methodcontrast source inversion,FEM-CSI)来重建粮仓内粮食的电学特性图,以提高粮食储存的可靠性和效率。Samir Trabelsi 等[4]通过研究电磁波与粮食介电常数的关系,提出了一种利用电磁波探测粮仓内粮食储量的方法。Lei Li 等[5]开发了一种基于深度学习的监测系统,通过语义分割技术自动检测粮仓内粮食数量的变化,提高了粮食存储监控的效率和准确性。 李智等 [6] 使用DeeepLabV3+模型和 MobileNetV2 特征提取网络,对粮仓内摄像机采集的图像进行分析,实现对粮仓内粮食数量变化的动态监测,为粮食存储安全提供了新的技术手段。然而,并非所有采集的图像都能提供清晰可见的粮面边缘,对于那些异常图像,实现粮面数量的动态监测变得困难。因此,对这些异常图像进行分类并将其转换为标准图像显得尤为关键,而粮仓仓内异常图像分类正是这一过程中的首要步骤。

近年来,经过众多科研工作者的持续探索,图像分类技术取得了较大进展。目前,常见的图像分类识别方法主要分为传统方法和基于机器学习方法。传统方法依赖手工提取特征,在面对新样本时准确性下降。因此,为了提升粮仓图像识别的精确度和鲁棒性,需要更先进的特征提取技术。基于机器学习的图像分类技术,特别是卷积神经网络,在医疗影像分析、自动驾驶汽车和图像检索等领域取得了突破性进展。Lei He 等[7]提出的 SV-ERnet 算法,通过结合 ResNet50 和SepViT,利用ESRGAN 提升图像分辨率,并采用加权软投票方法融合两种模型,结合Grad-CAM方法进行可视化解释,显著提高了识别准确率。Leo Ramos 等[8]将 ConvNeXt 模型与长短期记忆网络相结合,并测试了在训练阶段使用不同学习率的影响。结果表明,ConvNeXt 在图像描述系统中有较好的表现。杜慧江等[9]提出了一种基于CBAM-InceptionV3 迁移学习的食品图像分类模型,通过在InceptionV3 模型中嵌入CBAM 模块,以提升食品图像识别的准确率。Long Hoang 等[10]提出了一种结合新型分割技术和ShuffleNet 的轻量级深度学习框架,用于智能医疗中的多类皮肤病变分类,提高了分类的准确性和效率。

机器学习为粮仓异常状态图像分类问题提供了新的解决方案,该方法能够自动提取图像特征并具有良好的泛化能力。本文提出了一个基于改进ConvNeXt 的粮仓图像分类方法,引入了CA注意力机制(Coordinate attention,CA)和Lion优化器,构建了ConvNeXt-L-CA 模型。通过利用视频监控对仓内图像进行采集,并使用数据增强技术扩充训练样本,通过在同一数据集上对比不同模型的性能指标,验证了改进后的ConvNeXt-L-CA模型在粮仓图像异常状态分类任务上的有效性。

1 材料与方法

1.1 图像数据集采集与处理

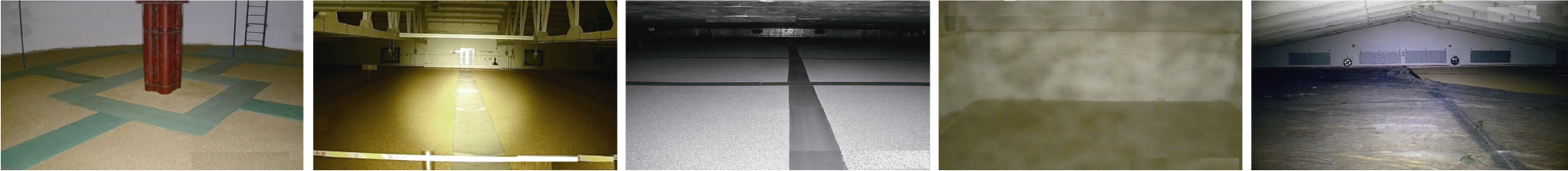

本研究所选用的数据集由中国华北和华东地区的多个粮仓仓内视频监控设备采集的图像构成,所涉及的粮仓类型多样,规模不一,包括了大型立筒仓和传统平方仓等。在数据预处理阶段,首先剔除因网络丢包导致花屏、黑屏的图像,然后筛掉粮仓异常特征不明显的图像,最后删除所有可能产生歧义的图像,最终筛选出包含粮面异物遮挡、画面过度曝光、画面过暗、画面模糊、粮面覆膜5 类仓内典型异常情况数据集,共计11 389 张,将其按照8∶1∶1 的比例分配到训练集、验证集和测试集中,各类数据集的示例图像如图1 所示。其中,画面过度曝光类别训练样本最少,仅有436张图片,而其他4 类的训练样本均有约2 000 张图片,为平衡样本数量,采用水平垂直翻转、增加高斯噪声等数据增强的方法对画面过度曝光类别的训练样本进行扩充,最终有12 514 张图片作为本实验的数据集。为简化模型的训练与评估,对来自不同地区粮仓监控系统捕获的图像进行标准化处理,将所有图像调整为统一的224×224 像素尺寸,并进行归一化操作,以消除不同分辨率带来的影响,确保数据的一致性。

图1 数据集图片实例

Fig.1 Example of a dataset image

1.2 实验平台与参数

本实验所使用的硬件环境为Intel Core i5,运行速度为2.50 GHz,内存为16 GB,显卡为NVIDIA GeForce RTX 3060 12 GB。使用的编程语言为Python 3.9,代码可视化工具为PyCharm,软件栈包括PyTorch 版本2.2.0 和CUDA 版本12.1。在模型训练过程中,对每个模型的参数进行调整,以确定最佳的学习率。除改进的ConvNeXt 模型使用 Lion 优化器外,其他所有模型都均使用AdamW 优化器。在训练阶段,统一使用交叉熵损失函数来衡量模型的预测误差。所有网络模型的训练次数均为100 轮次,以确保模型能够充分学习并优化其性能。

1.3 评估指标

为便于对不同模型的性能进行比较,本研究采用了准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1 指数(F1-score)这4 个关键指标来评估模型的表现,这些指标能综合反映模型在分类任务中的优劣性、稳定性和鲁棒性。

准确率是模型正确分类的图像数量占总图像数量的比例,它是最直观的性能指标。具体计算过程见公式(1)。

精确率是在所有被预测为正类的图像中,实际为正类的比例。它衡量了模型预测正类的准确性,具体计算过程见公式(2)。

召回率是在所有实际为正类的图像中,被正确预测为正类的比例,它衡量了模型捕捉正类的能力,具体计算过程见公式(3)。

F1 指数是精确率和召回率的调和平均数,它在两者之间取得平衡,是一个综合考虑精确率和召回率的性能指标,具体计算过程见公式(4)。

其中,TP 代表真阳性、FP 代表假阳性、TN代表真阴性和FN 代表假阴性,分别表示被正确分类的正例、被错误分类的正例、被正确分类的反例和被错误分类的反例的样本数。

1.4 改进的ConvNeXt 模型

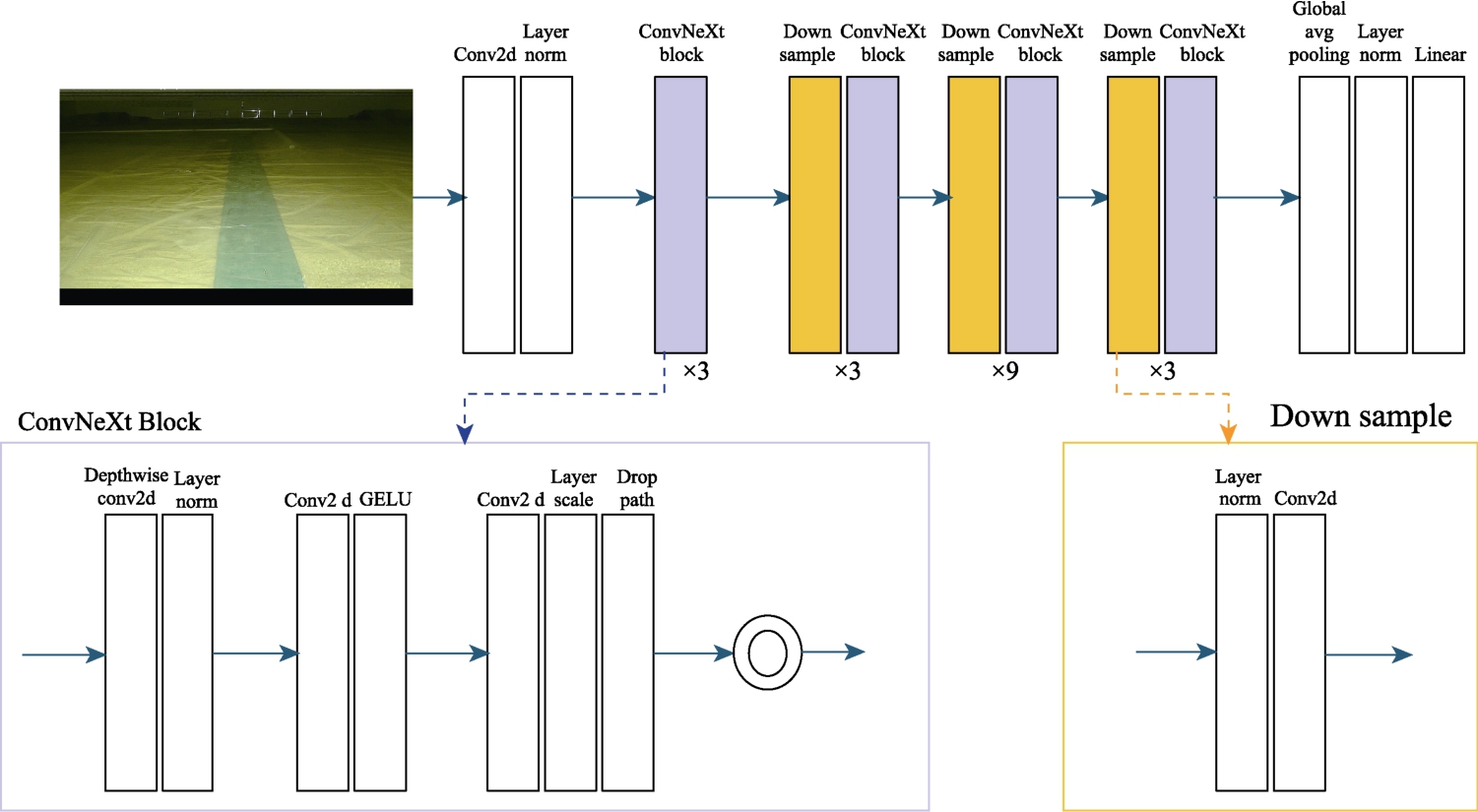

本实验用到的骨干网络ConvNeXt 是一种新型的卷积神经网络架构,主要包括 ConvNeXt Block 块、DownSample 块和平均池化模块等,其网络模型如图2 所示[11]。它以Resnet50 网络作为基准网络并根据ViT 的训练策略进行改进得到的,旨在融合现代卷积操作和Transformer 思想以提升视觉任务表现,通过采用较大的卷积核和深度网络结构,增强了特征提取能力和训练稳定性,同时保留了传统CNN 中的残差连接和层归一化(LayerNorm)。此外,ConvNeXt 在设计上借鉴了Transformer 模型中的创新思想,使得卷积网络在处理长程依赖和复杂特征时更加高效,并保持了较高的计算效率和模型简洁性。该模型在图像分类、目标检测等任务中表现出色,具有较强的表现力和计算效率。然而,ConvNeXt 对计算资源的需求较高,特别在处理大规模数据集时,可能会对硬件提出较大的要求,且其较为复杂的架构也需要更多的调参和训练技巧。

图2 ConvNeXt 整体结构

Fig.2 The overall structure of the ConvNeXt

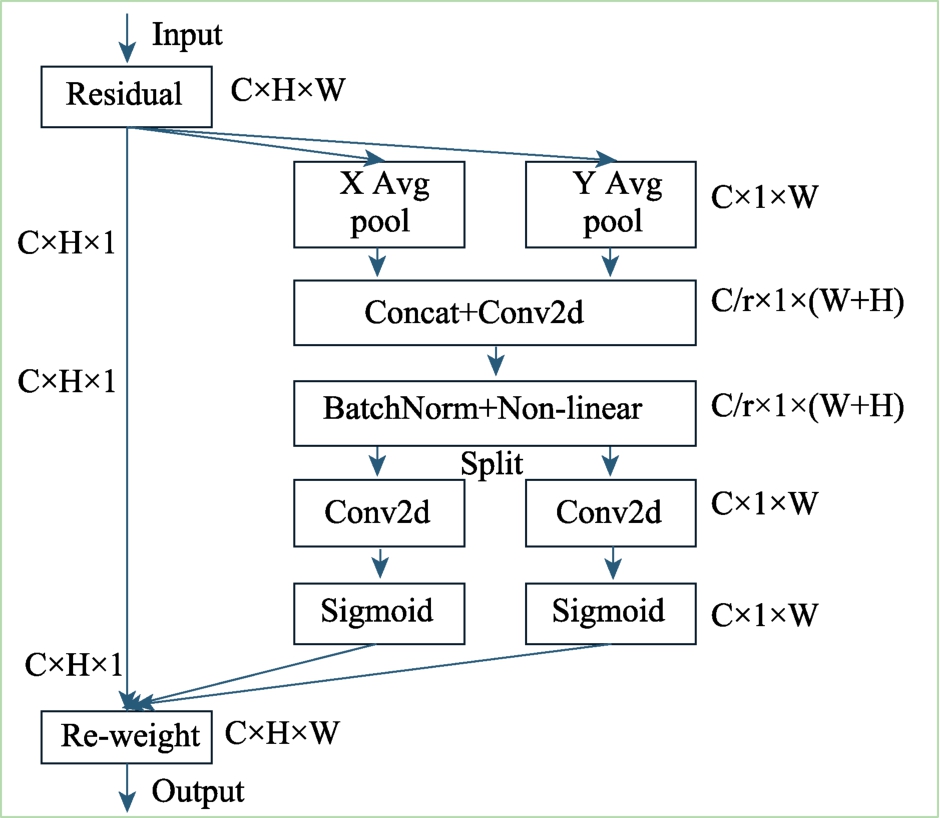

为了提升模型对输入数据中关键信息的聚焦能力,决定引入注意力机制。在对ECA-Net(Efficient channel attention network)、CA-Net(Coordinate attention)、SE-Net(Squeeze-and-excitation networks)以 及 CBAM ( Convolutional block attention module)注意力模块进行对比分析后,选用CA-Net 作为本模型的注意力模块[12-14]。CA 注意力机制是一种增强移动网络性能的技术,它通过将位置信息整合到通道注意力中来实现。与使用2D 全局池化将特征映射压缩成一个单一的特征向量的通道注意力机制不同,CA 注意力机制采用两个1D 全局池化操作,分别沿着垂直轴和水平轴对输入特征进行聚合,生成两个方向信息的特征图,从而能够捕捉到更丰富的空间关系。这两个特征图随后分别被编码成两个注意力图,每个图都能够捕捉输入特征图沿一个空间方向的长距离依赖性[15]。CA 模块利用精确的坐标数据来编码通道间的关系以及长距离的依赖性,该过程主要包括两个环节:坐标信息嵌入和坐标注意力生成。其结构如图3 所示,其中,X Avg Pool,表示一维水平全局池化;Y Avg Pool,表示一维垂直全局平均池化。

图3 CA 注意力机制

Fig.3 CA attention mechanism

本研究提出的ConvNeXt-CA 网络架构如图4所示,其主要由3 个关键部分组成。首先,它采用了ConvNeXt Block 模块来进行特征提取,负责从输入数据中抽取关键信息;其次,网络中集成了拆分池化模块,对特征图进行下采样,以降低维度并提取更抽象的表示;最后,网络包含了CA注意力模块,该模块主要聚焦于输入数据中最显著的特征,从而提高模型对关键信息的敏感度。通过这种设计,ConvNeXt-CA 网络能够有效地处理和分析输入数据,实现更精准的特征识别和分类。

图4 ConvNeXt-CA 整体结构

Fig.4 ConvNeXt-CA monolithic structure

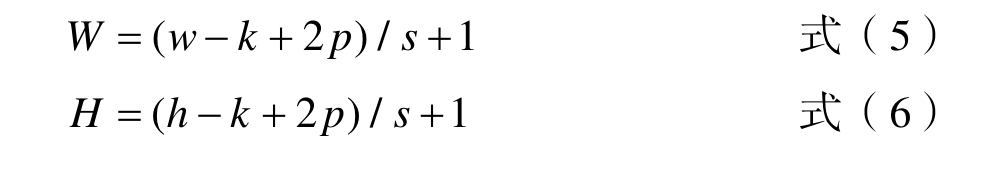

改进型ConvNeXt 模型在处理粮仓图像分类任务中,首先接收尺寸为224×224 像素的三通道彩色图像。接着,利用步长为4、核大小为4×4的卷积层来捕获图像的浅层特征并进行层归一化处理,输出尺寸为56×56 像素、通道数为96 的特征图。最后,模型通过一系列的ConvNeXt 块、注意力模块和下采样模块进一步提取和精炼特征,增强了模型对关键特征的识别能力,同时减少了对复杂背景的干扰,使得模型在执行粮仓异常检测任务时能够更精确地识别和定位问题区域。特征图的宽和高的计算公式为公式(5)和(6),其中k 为卷积核的尺寸,s 为卷积的步长,h 和H分别代表卷积前和卷积后特征图的高度,w 和W代表卷积前和卷积后特征图的宽度,p 为填充的大小。

1.5 Lion 优化器

Lion优化器,全称为“Least-squares Interpolation Optimizer with Noise”,是一种基于最小二乘差值和噪声注入的新颖优化策略,试图在保持快速收敛的同时,通过引入随机性避免过拟合。其核心思想是在每个迭代步长中结合梯度信息和前几个步长的更新趋势,以更平滑且有针对性的方式调整权重。为了实现更快的运行时间、更高的显存效率以及更好的泛化能力,在模型训练过程中使用Lion 优化器以此替代ConvNeXt 模型中原有的AdamW 优化器,并将Lion 优化器的初始学习率设定为 0.000 1,权重衰减系数为0.01。它适用于各种深度学习任务,特别是需要大量计算资源的大规模模型训练,如自然语言处理、计算机视觉以及文本到图像生成等,多数任务显示Lion 比目前主流的AdamW、Adam、Radam 等优化器有着更好的性能[16]。

2 结果与分析

2.1 对比实验

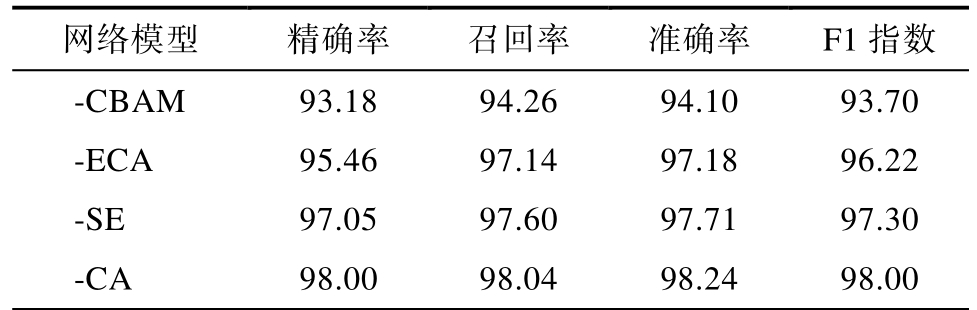

2.1.1 注意力机制对比实验

为了验证采用CA 注意力机制的优越性,将本研究改进的ConvNeXt 模型中的CA 注意力模块分别替换为高效的通道注意力模块ECA、混合注意力机制模块CBAM、通道注意力模块SE 进行比较,实验结果如表1 所示。本文使用的CA注意力机制具有最高的准确率,分别高于CBAM、ECA、SE 注意力机制4.14、1.06、0.53 个百分点,分类效果达到最优。这是因为坐标注意力机制CA可以将位置信息融入通道注意力中,通过在两个空间维度(高度和宽度)上分别进行注意力的计算,能够更精确地捕捉到图像中的空间分布特征,从而更全面地捕获特征间的依赖关系。

表1 添加不同注意力机制的比较

Table 1 Comparison of adding different attention mechanisms %

网络模型精确率召回率准确率F1 指数-CBAM 93.18 94.26 94.10 93.70-ECA 95.46 97.14 97.18 96.22-SE 97.05 97.60 97.71 97.30-CA 98.00 98.04 98.24 98.00

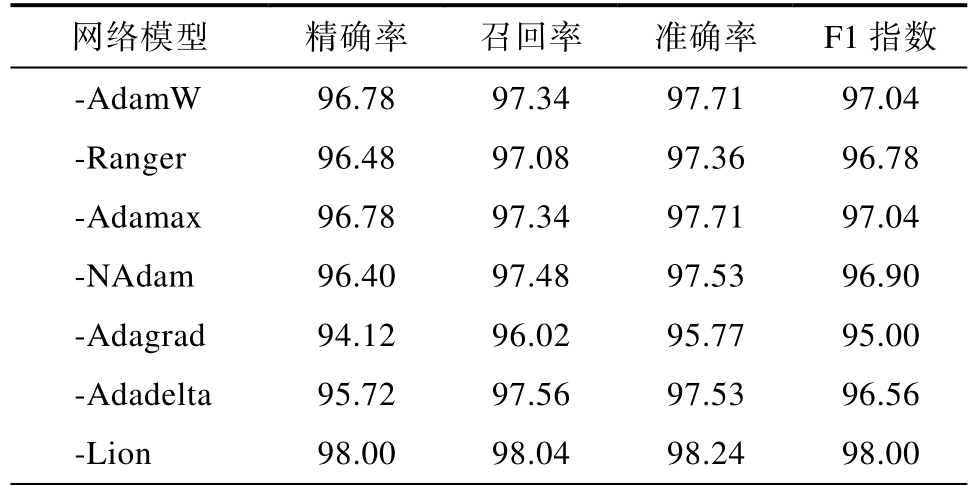

2.1.2 优化器对比实验

为了验证Lion 优化器的优势,将本研究改进的ConvNeXt 模型中的Lion 优化器分别替换为AdamW、RangerAdamax、NAdam、Adagrad、Adadelta 进行比较,实验结果如表2 所示,本研究使用的Lion 优化器具有最高的精确率、召回率、准确率、F1 指数,分别为97.50%、97.88%、97.97%、97.66%。在与其他模型相比,精确率提高了1~4 个百分点、召回率提高了0.4~2 个百分点、准确率提高了0.5~3 个百分点、F1 指数提高了0.9~3 个百分点,实现了分类效果的提升,验证了Lion 优化器在粮仓内部图像分类任务中所展现出的显著优势。

表2 使用不同优化器的比较

Table 2 Comparison of using different optimizers %

网络模型精确率召回率准确率F1 指数-AdamW 96.78 97.34 97.71 97.04-Ranger 96.48 97.08 97.36 96.78-Adamax 96.78 97.34 97.71 97.04-NAdam 96.40 97.48 97.53 96.90-Adagrad 94.12 96.02 95.77 95.00-Adadelta 95.72 97.56 97.53 96.56-Lion 98.00 98.04 98.24 98.00

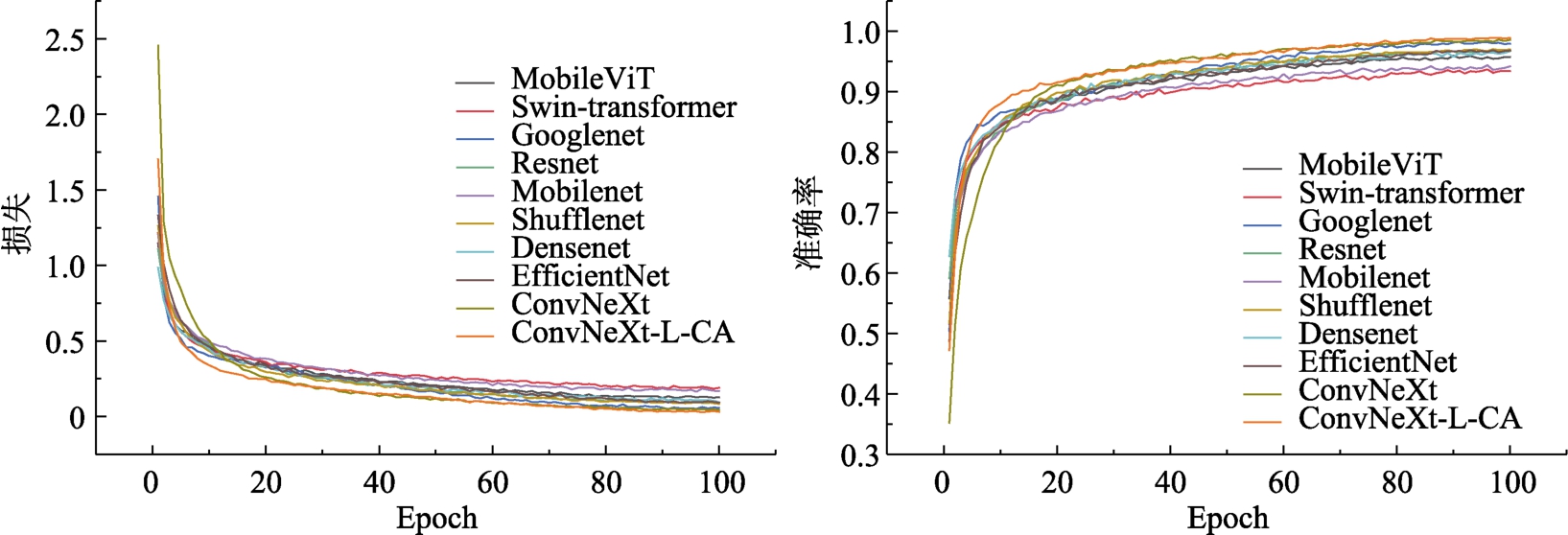

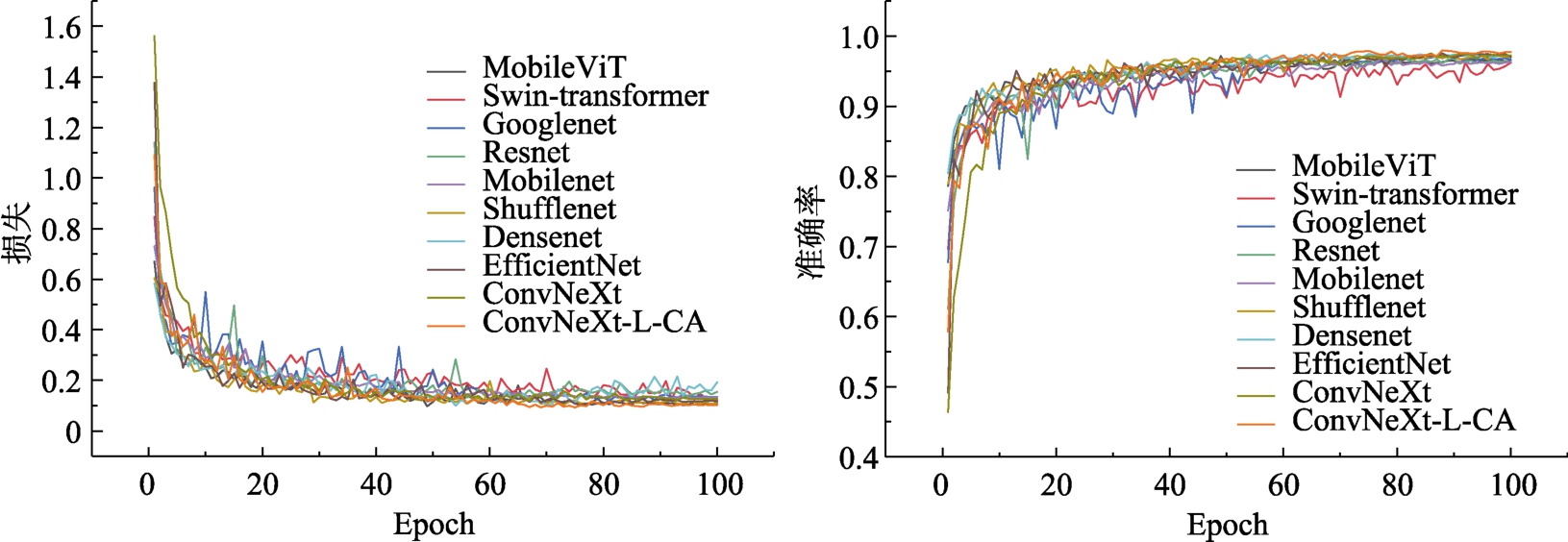

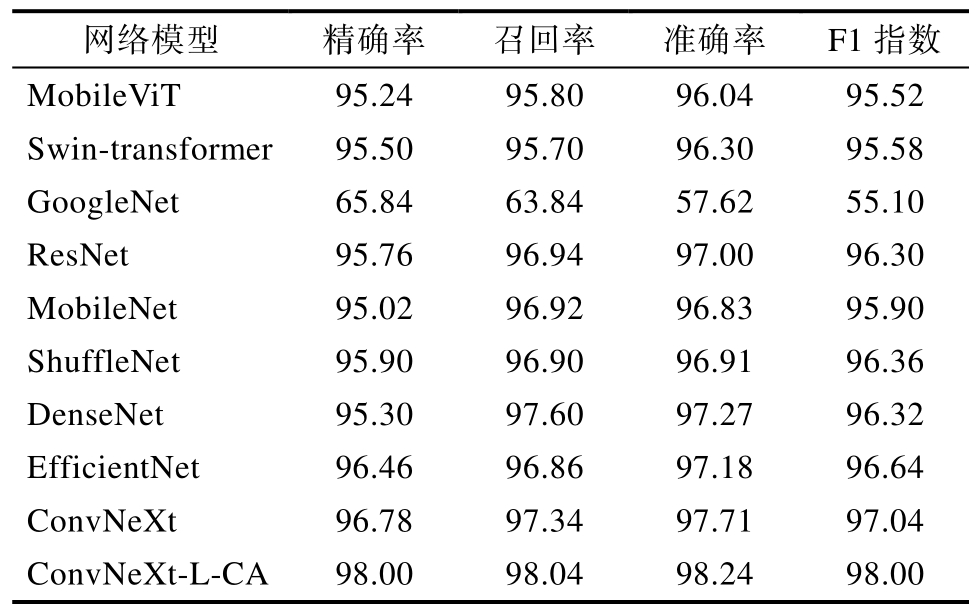

2.1.3 与其他模型对比实验

为了验证本研究提出的模型在粮仓内部图像分类任务中的优越性,在相同的数据集和实验条件下,将MobileViT、Swin Transformer、GoogleNet、ResNet 、 MobileNet 、 ShuffleNet 、 DenseNet 、EfficientNet、ConvNeXt 以及改进的ConvNeXt-LCA 在内的10 种模型进行训练和比较,迭代次数为100 轮,记录此周期每一批次的训练集损失、训练集准确率、验证集损失和验证集准确率,以便于及时掌握模型的训练情况,避免模型过拟合等影响训练,确保模型能够完成迭代周期的训练。其中,训练集的损失值与准确率的对比曲线如图5 所示。相较于其他模型,ConvNeXt-L-CA 在20个迭代周期后,训练集上准确率始终最高且损失值始终最低。验证集的损失值与准确率的对比曲线如图 6 所示。ConvNeXt-L-CA 模型相较于GoogleNet、ResNet、ShuffleNet 等模型取得了更好的结果,它收敛速度较快,波动较小,趋于稳定后的准确率更高,损失值更低。

图5 各模型训练集的损失值与准确率的对比曲线

Fig.5 Comparison curve of the loss value and accuracy of each model training set

图6 各模型测试集的损失值与准确率的对比曲线

Fig.6 Comparison curves of the loss value and accuracy of each model test set

从表3 可以看出,改进的ConvNeXt 模型与其他模型相比,其性能在各项指标上均表现最优,准确率、精确率、召回率和F1 指数分别达到了98.24%、98.00%、98.04%、98.00%。其中,准确率比原模型高0.53 个百分点,精确率比原模型高1.22 个百分点,召回率比原模型高0.7 个百分点,F1 指数比原模型高0.96 个百分点。验证了改进型ConvNeXt 模型的优越性,证明了该模型能有效地处理粮仓仓内图像的分类问题。

表3 不同分类模型结果对比

Table 3 Comparison of the results of different classification models %

网络模型精确率召回率准确率F1 指数MobileViT 95.24 95.80 96.04 95.52 Swin-transformer 95.50 95.70 96.30 95.58 GoogleNet 65.84 63.84 57.62 55.10 ResNet 95.76 96.94 97.00 96.30 MobileNet 95.02 96.92 96.83 95.90 ShuffleNet 95.90 96.90 96.91 96.36 DenseNet 95.30 97.60 97.27 96.32 EfficientNet 96.46 96.86 97.18 96.64 ConvNeXt 96.78 97.34 97.71 97.04 ConvNeXt-L-CA 98.00 98.04 98.24 98.00

2.2 消融实验

为分析CA 注意力机制、Lion 优化方法对改进ConvNeXt 模型分类性能的影响,在粮仓仓内图像数据集上设计了消融实验来验证所提模型的性能,实验结果见表4。使用Lion 优化器的网络在测试集上的精确率、召回率、准确率、F1 指数分别为97.50%、97.88%、97.97%、97.66%,相比使用AdamW 优化器的基准网络分别提高了0.72、0.54、0.26、0.62 个百分点。引入注意力机制让网络在特征提取阶段捕捉输入数据中的关键信息,该网络在测试集上的精确率、召回率、准确率、F1 指数分别为97.26%、97.83%、97.82%、97.17%,相比基准网络分别提高了0.48、0.49、0.11、0.13个百分点。同时加入Lion 优化方法和CA 注意力机制的网络在在测试集上的精确率、召回率、准确率、F1 指数分别为98.00%、98.04%、98.24%、98.00%,相较于基准网络分别提升了1.22、0.7、0.53、0.96 个百分点,达到了最好的分类效果,说明本文的改进是有效的,提升了粮仓仓内异常图像分类任务的性能。

表4 不同优化方法的比较

Table 4 Comparison of different optimization methods %

网络模型精确率召回率准确率F1 指数ConvNeXt 96.78 97.34 97.71 97.04 ConvNeXt-Lion 97.50 97.88 97.97 97.66 ConvNeXt-CA 97.26 97.83 97.82 97.17 ConvNeXt-L-CA 98.00 98.04 98.24 98.00

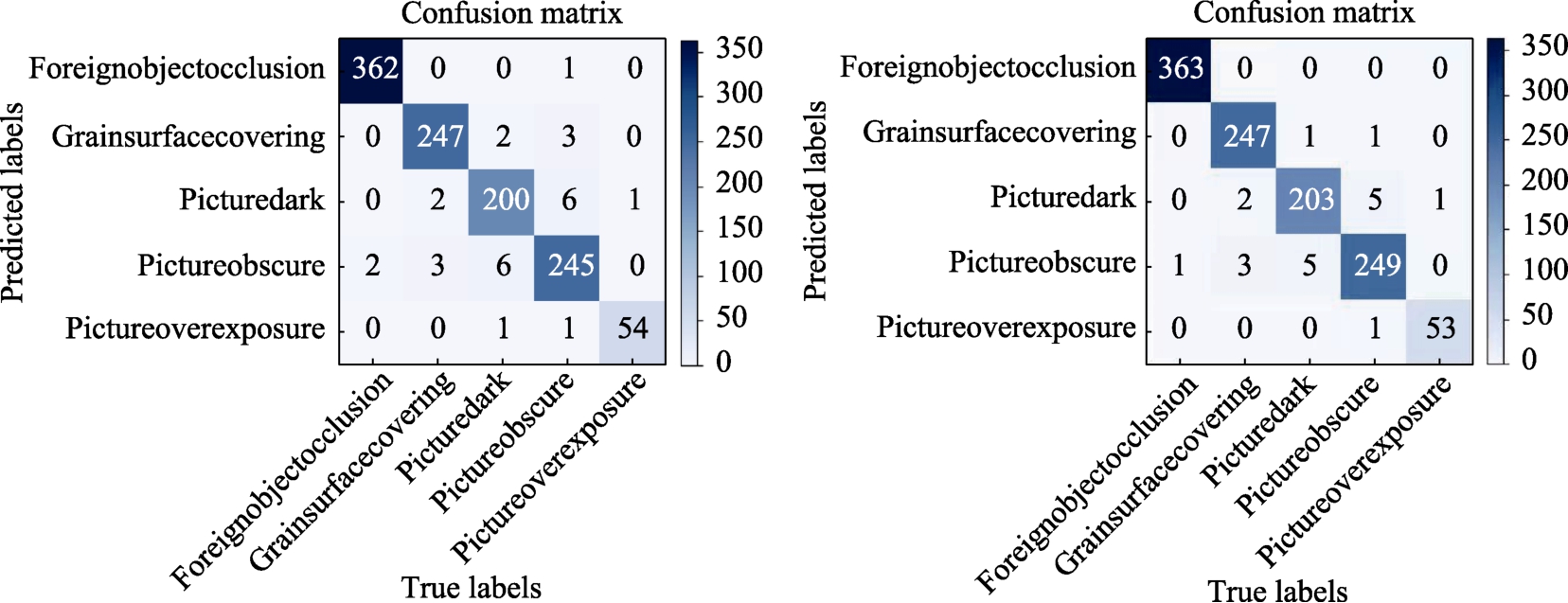

2.3 可视化分析

为了全面验证本研究改进模型的有效性,对实验结果进行混淆矩阵的可视化对比分析,图7清晰地展示了原始 ConvNeXt 模型与改进后的ConvNeXt 模型在混淆矩阵上的差异。在混淆矩阵中,对角线上的值代表了每个类别被正确预测的实例数,而非对角线上的值则表示了被错误分类的实例数[17]。

图7 混淆矩阵对比图

Fig.7 Comparison of the confusion matrix

注:左:原始ConvNeXt 模型;右:改进的ConvNeXt 模型 Note: Left:Original ConvNeXt model; right:improved ConvNeXt model

通过对比可观察到,在图7(右)中,对角线上的数值较图7(左)有所提升,这表明改进模型在图像分类任务中正确预测标签与实际标签一致的样本数量有所增加,从而有效降低了粮仓内部图像分类的误判率。同时,图7(右)中非对角线上的数值相较于图7(左)有所下降,这说明改进的ConvNeXt 模型减少了将其他类别错误预测为正常类别的情况,即降低了分类任务中的漏检率。这些结果证明了改进的ConvNeXt 模型在提高粮仓仓内图像分类准确性方面的优势。

3 结论

为提高粮仓仓内图像分类的准确性,本研究提出一种ConvNeXt-L-CA 的仓内图像分类方法。对ConvNeXt 模型进行拆分,在每一个ConvNeXt-Block 块后均嵌入CA 注意力模块,并在训练时使用Lion 优化器,从而构建了完整的ConvNeXt-LCA 模型,使用该模型对粮仓图像数据集进行训练,最终完成粮仓仓内图像的分类任务。该模型能够有效区分出5 种典型的粮仓仓内异常情况的图像,在测试集上的精确率、召回率、准确率、F1 指数相较于基准网络分别提升了1.22、0.7、0.53、0.96 个百分点,验证了改进的ConvNeXt模型具有良好的仓内图像识别与分类的能力,对粮库的信息化监管提供了技术支撑。

[1] 毛绿萱, 李鑫. 总体国家安全观视角下中国粮食安全的定位、实践与影响[J]. 粮油食品科技, 2023, 31(4): 1-9.MAO L X, LI X. The positioning, practice and impact of China's food security from the perspective of overall national security[J].Science and Technology of Cereals, Oils and Foods, 2023, 31(4):1-9.

[2] 李晨宇. 我国粮食储备安全管理研究[D]. 太原:山西大学,2023.LI C Y. Research on the security management of grain reserves in China[D]. Taiyuan: Shanxi University, 2023.

[3] ASEFI M, JEFFREY I, LOVETRI J, et al. Grain bin monitoring via electromagnetic imaging[J]. Computers and Electronics in Agriculture, 2015, 119: 133-141.

[4] SAMIR T, STUART O N. On the accuracy of bulk density and moisture content prediction in wheat from near field free space measurements[J]. Technisches Messen, 2007, 74(5): 280-289.

[5] LI L, DONG Z, YANG T, et al. Deep learning-based automatic monitoring method for grain quantity change in warehouse using semantic segmentation[J]. IEEE Transactions on Instrumentation and Measurement, 2021, 70: 1-10.

[6] 李智, 张艳飞, 杨卫东, 等. 基于语义分割的粮仓粮食数量变化动态监测方法[J]. 中国粮油学报, 2024, 39(4): 131-139.LI Z, ZHANG Y F, YANG W D, et al. Dynamic monitoring method of grain quantity change in granary based on semantic segmentation[J]. Journal of the Chinese Cereals and Oils Society,2024, 39(4): 131-139.

[7] HE L, WEI H, GAO W. Research on an intelligent classification algorithm of ferrography wear particles based on integrated ResNet50 and SepViT[J]. Lubricants, 2023, 11(12): 530.

[8] RAMOS L, CASAS E, ROMERO C, et al. A study of convnext architectures for enhanced image captioning[J]. IEEE Access, 2024.

[9] 杜慧江, 崔潇以, 王艺蒙, 等. 基于CBAM-InceptionV3 迁移学习的食品图像分类[J]. 粮油食品科技, 2024, 32(1): 91-98.DU H J, CUI X Y, WANG Y M, et al. Food image classification based on CBAM InceptionV3 transfer learning[J]. Science and Technology of Cereals, Oils and Foods, 2024, 32 (1): 91-98.

[10] HOANG L, LEE S H, LEE E J, et al. Multiclass skin lesion classification using a novel lightweight deep learning framework for smart healthcare[J]. Applied Sciences, 2022, 12(5): 2677.

[11] LIU Z, MAO H, WU C Y, et al. A convnet for the 2020s[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2022: 119.

[12] ZHANG P, JIANG M, LI Y, et al. An efficient ECG denoising method by fusing ECA-Net and CycleGAN[J]. Mathematical Biosciences and Engineering, 2023, 20(7): 13415-13433.

[13] FENG Y, LIU C, HAN J, et al. IRB-5-CA Net: a lightweight,deep learning-based approach to wheat seed identification[J].IEEE Access, 2023, 11: 119553-119559.

[14] NAKAJIMA M, TANAKA K, HASHIMOTO T. Neural schrödinger equation: physical law as deep neural network[J].IEEE Transactions on Neural Networks and Learning Systems,2021, 33(6): 2686-2700.

[15] 齐爱玲, 王宣淋. 基于中层细微特征提取与多尺度特征融合细粒度图像识别[J]. 计算机应用, 2023, 43(8): 2556-2563.QI A L, WANG X L. Fine-grained image recognition based on middle-layer subtle feature extraction and multi-scale feature fusion[J].Journal of Computer Applications, 2023, 43(8): 2556-2563.

[16] 时雷, 雷镜楷, 王健, 等. 基于改进FasterNet的轻量化小麦生育期识别模型[J]. 农业机械学报, 2024, 55(5): 226-234.SHI L, LEI J K, WANG J, et al. Lightweight wheat growth period recognition model based on improved FasterNet[J].Journal of Agricultural Machinery, 2024, 55(5): 226-234.

[17] 郭威, 史运涛. 基于空间域图像生成和混合卷积神经网络的配电网故障选线方法[J]. 电网技术, 2024, 48(3): 1311-1328.GUO W, SHI Y T. A fault routing method for distribution networks based on spatial domain image generation and hybrid convolutional neural network[J]. Grid Technology, 2024, 48(3):1311-1328.